[TOC]

认识HBase

HBase介绍

HBase = Hadoop database,Hadoop数据库

开源数据库

官网:hbase.apache.org/

HBase源于Google的BigTable

Apache HBase™是Hadoop数据库,是一个分布式,可扩展的大数据存储。

当需要对大数据进行随机、实时读/写访问时,请使用Apache HBase™。该项目的目标是托管非常大的表 - 数十亿行X百万列 - 在商品硬件集群上。Apache HBase是一个开源的,分布式的,版本化的非关系数据库nosql,模仿Google的Bigtable: Chang等人的结构化数据分布式存储系统。正如Bigtable利用Google文件系统提供的分布式数据存储一样,Apache HBase在Hadoop和HDFS之上提供类似Bigtable的功能。

HBase可执行基于Yarn平台的计算任务,但不擅长。

< !–more–>

HBase集群角色

- HDFS:

- NameNode——主节点

- DataNode——数据存储节点

- Yarn:

- ResourceManager——全局的资源管理器

- NodeManager——分节点资源和任务管理器

- HBase:

- HMaster

- 负责Table表和RegionServer的监控管理工作

- 处理元数据的变更

- 对HRegionServer进行故障转移

- 空闲时对数据进行负载均衡处理

- 管理Region

- 借助ZooKeeper发布位置到客户端

- HRegionServer

- 负责Table数据的实际读写

- 刷新缓存数据到HDFS

- 处理Region

- 可以进行数据压缩

- 维护Hlog

- Region分片

hbase 架构

HRegionServer结构:

- HLog:存储HBase的修改记录

- HRegion:根据rowkey(行键,类似id)分割的表的分片

- Store:对应HBase表中的一个列族,可存储多个字段

- HFile:真正的存储文件

- MemStore:保存当前的操作

- ZooKeeper:存放数据的元数据信息,负责维护RegionServer中保存的元数据信息

- DFS Client:存储数据信息到HDFS集群中

安装

前期准备

服务器分配

| 主机名 |

IP |

| centos-node1 |

192.168.99.101 |

| centos-node2 |

192.168.99.102 |

| centos-node3 |

192.168.99.103 |

解压安装文件到指定目录

1

| $ tar -zxvf hbase-1.4.13.tar.gz -C 目标目录

|

修改配置文件

hbase-env.sh

1

2

3

4

5

6

7

8

9

10

|

export JAVA_HOME=jdk安装路径

export HBASE_MANAGES_ZK=false

|

hbase-site.xml

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

| <configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://centos-node1:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.master.port</name>

<value>16000</value>

</property>

<property>

<name>hbase.master.info.port</name>

<value>16010</value>

</property>

<property>

<name>hbase.regionserver.port</name>

<value>16201</value>

</property>

<property>

<name>hbase.regionserver.info.port</name>

<value>16301</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>centos-node1,centos-node2,centos-node3</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/usr/local/zookeeper/data</value>

</property>

</configuration>

|

regionservers

加入节点主机名

1

2

3

| centos-node1

centos-node2

centos-node3

|

解决依赖问题

1

2

3

| $ cd /usr/local/hbase/lib

$ rm -fr hadoop-*

$ rm -fr zookeeper-*

|

把相关版本的zookeeper和hadoop的依赖包导入到hbase/lib

软链接hadoop配置

1

2

| $ ln -s /usr/local/hadoop/etc/hadoop/core-site.xml /usr/local/hbase/conf/core-site.xml

$ ln -s /usr/local/hadoop/etc/hadoop/hdfs-site.xml /usr/local/hbase/conf/hdfs-site.xml

|

复制到其他节点

1

2

| $ scp -r /usr/local/hbase centos-node2:/usr/local/

$ scp -r /usr/local/hbase centos-node3:/usr/local/

|

配置环境变量

1

2

3

4

5

6

7

8

9

10

| JAVA_HOME=/usr/local/java/

JRE_HOME=$JAVA_HOME/jre

HADOOP_HOME=/usr/local/hadoop

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

ZOOKEEPER_HOME=/usr/local/zookeeper

HBASE_HOME=/usr/local/hbase

PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin:$HADOOP_HOME/bin:$ZOOKEEPER_HOME/bin:$HBASE_HOME/bin

export JAVA_HOME JRE_HOME PATH CLASSPATH HADOOP_HOME ZOOKEEPER_HOME HBASE_HOME

|

修改防火墙

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

$ firewall-cmd --get-active-zones

$ firewall-cmd --new-service=hbase --permanent

$ firewall-cmd --service=hbase --add-port 16000/tcp --permanent

$ firewall-cmd --service=hbase --add-port 16010/tcp --permanent

$ firewall-cmd --service=hbase --add-port 16201/tcp --permanent

$ firewall-cmd --service=hbase --add-port 16301/tcp --permanent

$ firewall-cmd --service=hbase --add-port 2181/tcp --permanent

$ firewall-cmd --reload

$ firewall-cmd --add-service=hbase

$ firewall-cmd --runtime-to-permanent

|

或者

1

2

| $ systemctl stop firewalld

$ systemctl disable firewalld

|

启动集群

- 启动主节点

hbase-daemon.sh start master

- 启动从节点

hbase-daemon.sh start regionserver

关闭集群

- 关闭主节点

hbase-daemon.sh stop master

- 关闭从节点

hbase-daemon.sh stop regionserver

UI 展示

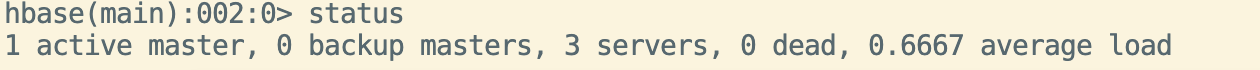

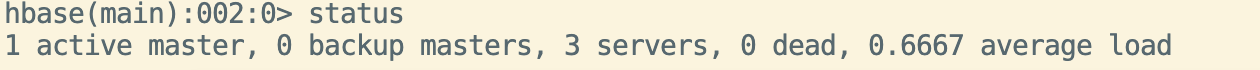

hbase shell的一些命令

1

2

|

$ create '表名', '列族1', '列族2'

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

|

$ scan '表名'

$ scan '表名', {STARTROW => 'Rowkey值', STOPROW => 'Rowkey值'}

$ describe '表名'

$ alter '表名', {NAME => '列族名', 变更字段名 => ' '}

$ get '表名', 'rowkey'

$ get '表名', 'rowkey', '列族:列名'

$ count '表名'

$ count '表名', 'rowkey'

$ put '表名', 'rowkey', '列族:列名', '值'

$ truncate '表名'

$ disable '表名'

$ drop '表名'

$ exit

$ quit

|

参考资源